오늘은 Cursor와 Ollama의 조합을 이용해서 돌려보고자 한다.

이럴 거면 왜 Cursor 쓰냐고 하는 사람도 있겠지만, 최근 deepseek나 phi4, qwen 같은 모델들은 코딩에 특화되어 있기 때문에 굳이 과금을 하며 사용할 필요가 없다고 느껴졌다. 그래서 Cursor에서 잘 구현해 놓은 기능들만 Local LLM으로 돌려보고자 하는 것이다.

사실 매우 간단한데, 사소한 오류가 있어서 애를 좀 먹었다.(Cursor의 단점이 아직 나온지 별로 안돼서 그런지, 가이드가 별로 없음.)

1. Ollama 설치

아마 이걸 검색해서 들어오신 분이라면 Ollama가 이미 뭔지 알고 있고, 대부분 사용중일 것이다.

LM studio나 뭐 여러개 있지만, Ollama가 가장 많이 사용되는 것 같다.

아무튼 Ollama 설치는 아래 링크를 참고하자.

[Ollama] Ollama & Open webui Install

오늘은 로컬에서 쉽게 LLM을 사용할 수 있도록 해준 Ollama를 설치해보도록 하겠다.(이번에 새로나온 llama:3.1 70B을 2080ti 7개로 돌리니 엄청빠르게 한글도 잘되고 똑똑한 놈을 사용 가능하다.) 우선

changsroad.tistory.com

2. Cursor 세팅

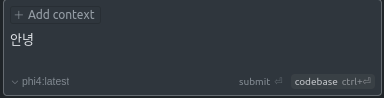

2-1. 모델 설정

Cursor의 설정의 Models에서 Ollama에 있는 모델을 작성해 주자. 그냥 그대로 작성해 주면 된다. ex) phi4:latest

그리고 나머지 모델들은 체크박스를 해제해준다.

다음으로 OpenAI API key 부분을 작성해줘야 한다.

Ollama에서는 OpenAI API Key 형태로 호출할 수 있게 만들어뒀으나, 실제로 api key 자체는 필요 없다. (이 부분이 가이드가 잘 없었음)

OpenAI API Key 부분에는 아무거나 작성해 주면 된다.(정말 아무거나. 비어있으면 안 된다.)

-> 만약 자신이 OpenAI API Key가 있고 그걸로 다른 모델들 사용 중이라면 그대로 내버려두어도 된다.

그리고 OpenAI Base URL에는 Ollama의 호출 api를 작성해 주면 된다. 대신 제일 마지막에 꼭 /v1을 붙여줘야 한다.ex) http://localhost:7869/v1

그런데!! 이렇게 하고 Save와 Verify를 누르면 에러가 뜬다.

이것 때문에 OpenAI API Key가 잘못된 건가... 하면서 정말 많은 시간을 헤맸고, 찾아봐도 잘 나오지 않다가 결국 발견했다.

(더 화났던 이유는 저기 Error 메시지에서 제공해 주는 Command를 실행해 보라고 해서 해보면, Ollama API가 잘 호출된다;; )

해결책부터 말하자면, Ollama를 Docker로 띄웠다면 거기다가 환경변수를 추가해줘야 한다.

나는 `docker-compose.yml`을 이용해서 올렸기 때문에 거기다가 환경변수를 추가해 줬다.

version: '3.8'

services:

ollama-service:

image: {OLLAMA_IMAGE}

environment:

- OLLAMA_ORIGINS=*

혹은 아래와 같이 추가해 주면 된다.

docker run -e OLLAMA_ORIGINS="*" {OLLAMA_IMAGE}

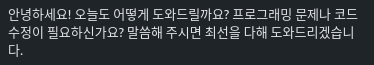

그럼 아래와 같이 Ollama에 있는 모델을 이용해서 Cursor과 함께 쓸 수 있다.

즉 핵심은 2개!!! OpenAPI Key를 비우지 말되, 아무거나 적기 + Ollama 환경변수 등록해 주기

Reference

Mem

Let AI organize your team’s work—from meeting notes, projects, to knowledge bases. All instantly searchable and readily discoverable.

mem.ai

'알쓸신잡' 카테고리의 다른 글

| PostgreSQL 환경설정 (0) | 2025.02.21 |

|---|---|

| Obsidian Icloud calendar 동기화 (0) | 2025.02.20 |

| 오픈소스 원격접속 프로그램 RustDesk (0) | 2025.02.03 |

| Cursor flask error: debug mode (0) | 2025.01.23 |

| Docker 컨테이너와 파일 주고받기 (0) | 2025.01.20 |