이번 글에서는 딥러닝의 발전에 크게 기여한 모델들에 대하여 간단하게만 알아볼 것이다.

1. LeNet-5

1998년 Yann LeCun에 의해 제안된 LeNet-5 모델은 손글씨 숫자를 인식하기 위해 설계된 최초의 합성곱 신경망 구조이다.

2. ILSVRC

Mnist 데이터 셋에 대하여 모델들이 성능이 뛰어나자 새로운 데이터 셋을 생성하였다.

ILSVRC: ImageNet Large Scale Visual Recognition Challenge라고 부르며, 수백만 개의 이미지로 구성된 데이터베이스로, 각 이미지는 라벨이 붙어 있어 다양한 컴퓨터 비전 연구에서 사용된다. ImageNet 자체는 거대한 이미지 데이터베이스이며, ILSVRC는 이 데이터셋을 이용해 2010~2017년에 개최된 대회로, 여러 비전 작업의 성능을 평가하기 위해 시작되었다.

3. AlexNet

AlexNet은 2012년 ImageNet 대회에서 큰 차이로 우승하여 딥러닝의 시대를 개시한 모델로, GPU를 이용한 효율적인 병렬 학습, ReLU 활성화 함수, 여러 계층 구조 등의 특징이 있다.

AlexNet

0. AlexNet 이번에 소개할 모델은 AlexNet이다. AlexNet은 2012년 ImageNet 대회의 우승을 차지한 CNN구조의 모델이다. AlexNet은 크게 Convolution, Pooling, Normalization layer로 구성되어 총 8개의 layer 구조이며 최종

changsroad.tistory.com

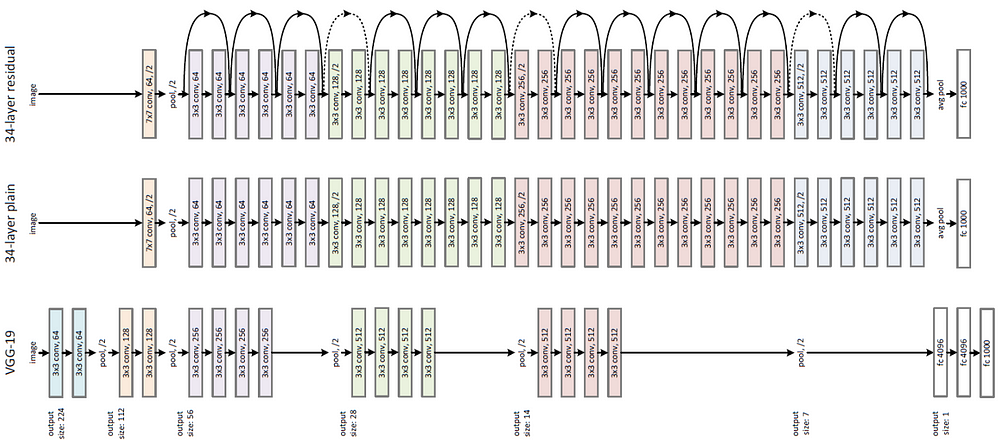

4. VGG

VGG 모델은 2014년 ImageNet 대회에서 좋은 성적을 낸 모델로, 깊은 네트워크의 성능을 입증하기 위해 16,19 레이어를 쌓은 버전이 개발되었다. 이는 합성곱 계층과 풀링 계층만으로 이루어진 기본적인 구조와 일관된 3x3 컨볼루션 필터크리와 레이어 깊이의 확장이 특징이다.

5. GoogLeNet

GoogLeNet은 2015년에 등장한 모델로, 복잡한 inception 모듈을 사용하여 네트워크의 파라미터 수를 줄이면서도 성능을 향상한 모델로, VGG 모델과 달리 다양한 크기의 합성곱 레이어와 풀링 레이어를 조합하였다.

6. GAN

GAN: Generative Adversarial Networks, 적대적 생성 신경망 모델은 2014년에 제안된 생성 모델이다.이는 생성자(Generator)와 판별자(Discriminator) 두 네티워크를 경쟁시켜 데이터의 분포를 학습하는 모델이다. 이미지/음성/텍스트 등 다양한 분야에서 뛰어난 결과를 보이며, 생성 모델링 분야의 혁신을 가져왔다.

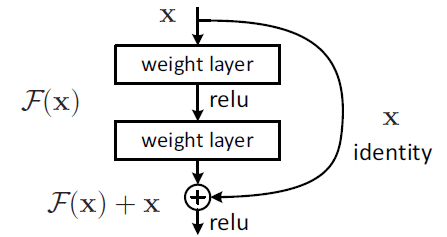

7. ResNet

ResNet은 2015년에 Imagenet 대회에서 우승하며 등장한 모델로, 사람보다 더 우수한 성능을 기록하게 되었다. 특징으로는 깊은 네트워크에서 발생하는 기울기 소실과 같은 문제를 해결하기 위해 Residual Connection을 도입한 모델로 이를 통해 수백 개의 레이어를 가진 네트워크도 효과적으로 학습하였다. 이는 네트워크의 깊이를 크게 확장하면서도 효율적인 학습이 가능하게 하였다.

8. Seq2Seq

Seq2Seq: Sequence-to-Sequence모델은 2014년에 등장한 모델로, 시퀀스를 입력받아 다른 시퀀스를 출력하는 문제에 특화된 구조이다. 주로 기계 번역과 같은 분야에서 사용되었으며, 크게 인코더와 디코더로 구성된 구조이다.

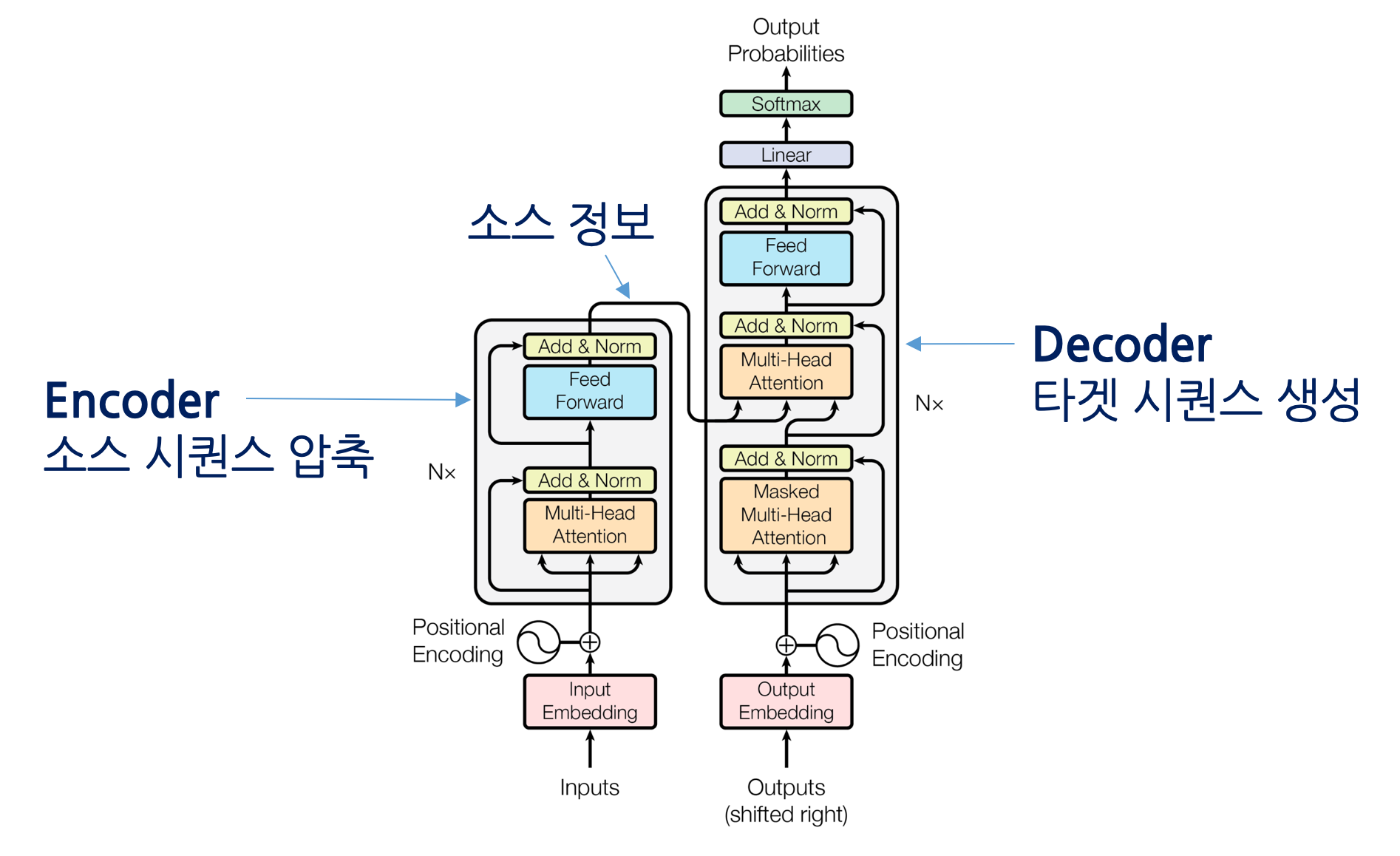

9. Transformer

Transformer은 2017년에 등장한 모델로, Self-Attention을 이용하여 시퀀스 데이터를 처리하며 RNN과 LSTM을 대체하는 새로운 방식으로 제안되어 많은 자연어 처리 모델의 기본이 되고 있다.

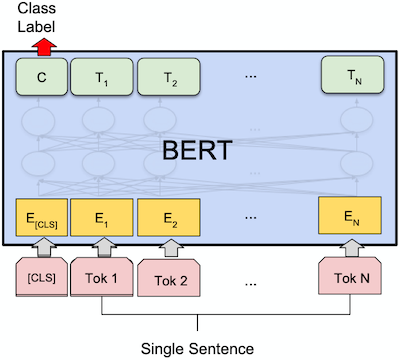

10. BERT

BERT:Bidirectional Encoder Representations from Transformers는 2018년에 언어 이해를 위해, 훈련된 양방향 Transformer구조를 사용하였다. 이 모델은 단순한 파인튜닝만으로 다양한 NLP작업에서 최첨단 성능을 달성하였으며, 문맥 양방향성에 크게 의존하여 단어의 의미를 파악하고 사전 훈련된 일반 언어모델을 사용하여 특정 작업에 적용되기 전에 대규모 텍스트 데이터에 대해 훈련되었다.

11. GPT

GPT:Generative Pre-trained Transformer도 2018년에 등장한 사전 훈련되 트랜스포머 기반의 모델로 초기에 비지도학습으로 큰 데이터셋에서 훈련된 후, 특정 작업을 위해 미세 조정한다. BERT와는 반대로 트랜스포머 구조의 디코더만을 사용하며 GPT-2,GPT-3를 발표하며 점점 스케일을 키워나가고 있다.

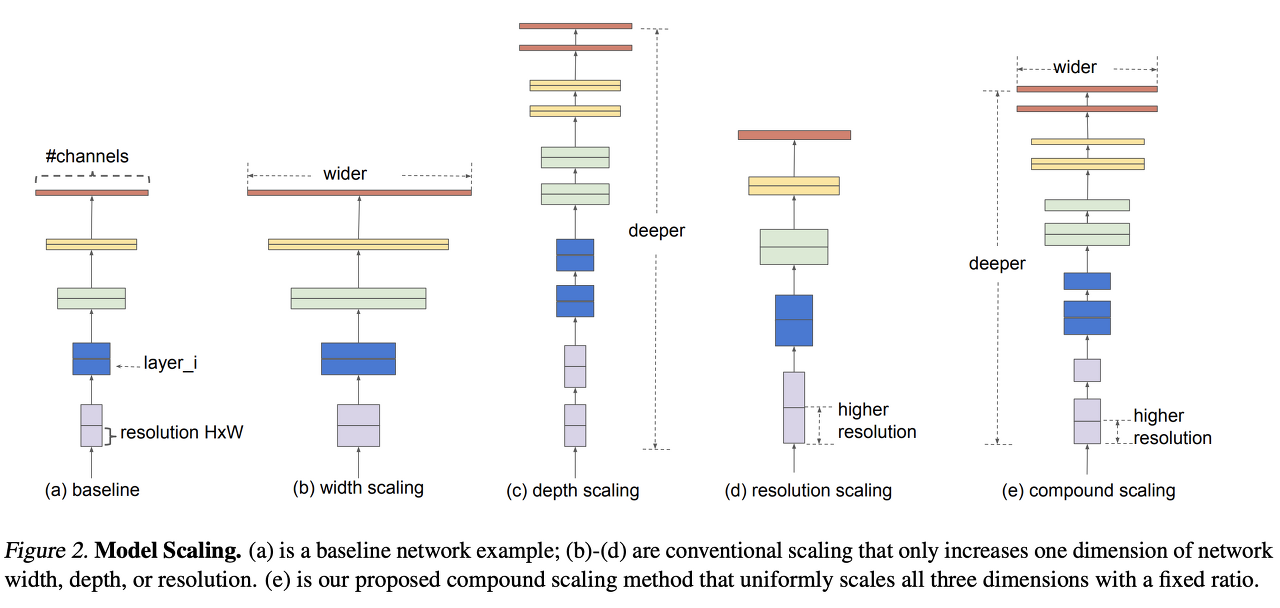

12. EfficientNet

EfficientNet은 2019년에 등장한 모델로, 컨볼루션 신경망의 모델 스케일링 방법을 새롭게 고려하여 설계된 구조로, 복잡도와 정확도 사이의 균형을 찾기 위해 너비, 깊이, 이미지해상도를 동시에 스케일링하는 방법을 제안하였다.

12. Vision Transformer

Vit:Vision Transformer은 주로 NLP에서 성공적으로 적용되었던 Transformer 구조를 이미지 인식에 활용하는 방법을 제시하였다. 이미지를 고정 크기의 패치로 나누고 이러한 패치를 sequence적인 토큰으로 변환하여 Transformer의 입력으로 사용하였고 이 모델은 큰 데이터셋과 큰 모델에서 최상의 성능을 발휘하여 CNN을 뛰어넘었다.

13. ChatGPT

OpenAI에서 개발한 GPT 구조를 기반으로 한 챗봇 전용 모델로, 대규모의 텍스트 데이터로 사전 학습된 후 다양한 채팅 데이터로 미세조정되어 사용자의 질문에 대응하는 응답 생성 능력을 갖췄다. 사용자와 자연스러운 대화를 나누는데 목적을 두며 다양한 주제와 컨텍스트에 유연하게 반응한다.

14. LLM

LLM, Large Language Model는 크게 기술을 공유하는 OpenLLM과 그렇지 않은 진영으로 나뉜다.

'ML & DL > 개념정리' 카테고리의 다른 글

| PyTorch 프로세스 (1) | 2024.01.09 |

|---|---|

| PyTorch-DNN, CNN을 이용한 MNIST 실습 (0) | 2024.01.02 |

| Linear, Lasso, Ridge Regression (0) | 2023.12.27 |

| Random Forest: 랜덤포레스트 (0) | 2023.12.26 |

| PyTorch- 텐서 조작 (0) | 2023.12.26 |