모델의 아키텍쳐를 구성할 때 얼마나 많은 layer(depth), 얼마나 많은 픽셀 resolution. 얼마나 많은 filter을 사용할지를 찾아주는 Compound scaling을 방식을 사용

→ 모델의 크기와 연산량를 결정하는 요소들(input resolution, depth, width)을 동시에 고려하여 증가시키는 방법.

EfficientNet이 제안했고 이 EficientNet을 backbone으로 사용한 모델이 EfficientDet이다.

EfficientNet의 compound scaling에 대하여 간단하게 설명하면,

Width와 resolution은 연산량에 거듭제곱형태로 연산량이 늘고, depth는 linear 하게 늘어나기 때문에, 같은 연산량에서 scaling을 해보기 위해, 아래와 같은 constraint를 세울 수 있다.

4번째 constraint 식에 2가 있는 것은 전체 연산량을 2의 ϕ 형태로 만들기 위함이다. 이렇게, 식을 세우고, ϕ를 고정하고, α, β, γ를 조금씩 넣어서 바꿔보는 노가다 알고리즘인 grid search를 하고, α, β, γ를 고정하고, ϕ를 늘려나가면서, 전체 size를 키우는 과정을 거쳐서, 최적의 비율을 찾아내는 것이 Efficientnet의 기본 컨셉이다.

EfficientDet은 compound scaling외에도 BiFPN(Bi-direction Feature Pyramid Network)을 추가적으로 사용하였는데, 이 BiFPN은 FPN에서 발전하였다.

FPN은 다양한 사이즈로 학습된 feature map을 이용하여 object detection을 하는데 이러한 feature map을 모두 저장하고 있다가 사용하게 되면 비효율적이게 되므로 여러 층에서 뽑힌 feature map을 잘 보완되게 만들어 다양한 사이즈의 이미지 모두에 맞게 detection 되도록 만들어준다.

Bi-FPN은 방금 설명한 FPN에 Cross-scale Connection과 weighted feature fusion을 추가한 알고리즘이다. Cross-Scale Connection부터 설명하면, 기존 FPN이 아래쪽으로만 정보를 흘려보내준다면, 아래 그림의 (b)처럼 위쪽 방향의 흐름도 만들어주자는 PANet이 제안되었고, Bi-FPN은 한 단계 더 나아가, 이를 여러 Layer 쌓고, connection을 만들어주는 구조를 택한다.

Weighted feature fusion은 (d)에서 P3~P7 등의 Input feature의 중요도가 다르니, 각각의 feature에 가중치를 줘서 output feature를 만들자는 내용이다.

FPN에서 서로 다른 resolution의 input feature들을 합칠 때, 일반적으로는 같은 해상도가 되도록 resize를 시킨 뒤 합치는 방식을 사용하는데 ,

모든 input feature들을 동등하게 처리를 하고 있는 점을 문제점으로 인식하고, 본 논문에서는 이 점을 개선하기 위해 각 input feature에 가중치를 주고, 학습을 통해 가중치를 배울 수 있는 방식을 제안

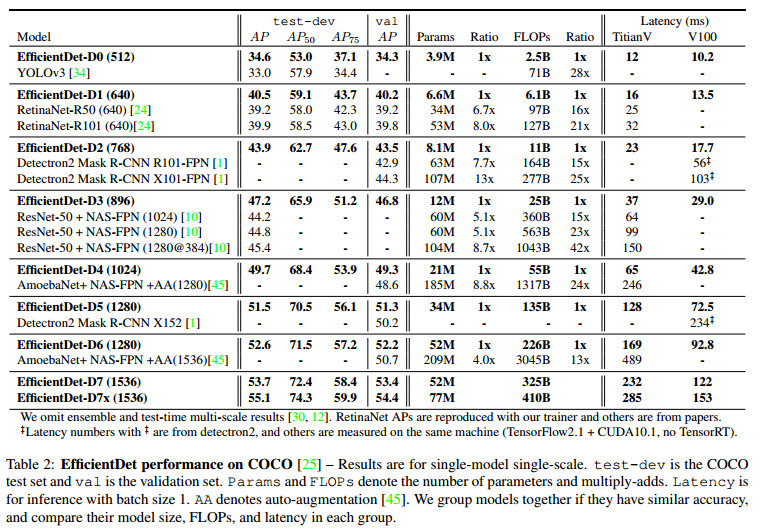

정리하면, Compound scaling을 통해, width/resolution/depth을 조절하는 Efficientnet을 Backbone으로 하고, Cross-scale connection/weighted feature fusion을 담은 Bi-FPN이 추가되어, Efficientdet이 제안되었다. Efficientnet의 scaling에 사용된 parameter인 ϕ를 바꾸면서, Efficientdet의 D0~D7까지 만들어졌고, 각각의 scale마다 Accuracy/AP 값과 연산량 FLOPs가 다른 것을 알 수 있다.

참고

EfficientDet : Scalable and Efficient Object Detection Review

“EfficientDet: Scalable and Efficient Object Detection

hoya012.github.io

[EfficientDet] 논문 리뷰: 가볍지만 성능은 좋은 object detector

EfficientNet과 마찬가지로 EfficientDet은 모델 사이즈를 최소화하고 성능을 최대화하는 효율성에 초점을 맞춘 object detection 모델이다. 이 논문은 EfficientNet을 backbone 네트워크로 사용하였고 bi-directional

greatjoy.tistory.com

Object Detection Algorithm (Efficientdet)

이번 리뷰에서 Object Detection Algorithm에서 사용되는 Efficientdet [1]에 대해 정리하려고 한다. Object Detection은 주어진 이미지에서 특정 위치에 어떤 물체가 있는지를 찾아내는 Task를 뜻하는데, Vision 관

engineering-ladder.tistory.com

'ML & DL > Computer vision' 카테고리의 다른 글

| U-Net (0) | 2023.10.26 |

|---|---|

| Image segmentation(recognition+localization) (0) | 2023.10.26 |

| YOLO: You Only Look Once (0) | 2023.10.26 |

| SSD(Single Shot MultiBox Detector) (0) | 2023.10.26 |

| R-CNN, Fast R-CNN, Faster R-CNN (0) | 2023.10.26 |